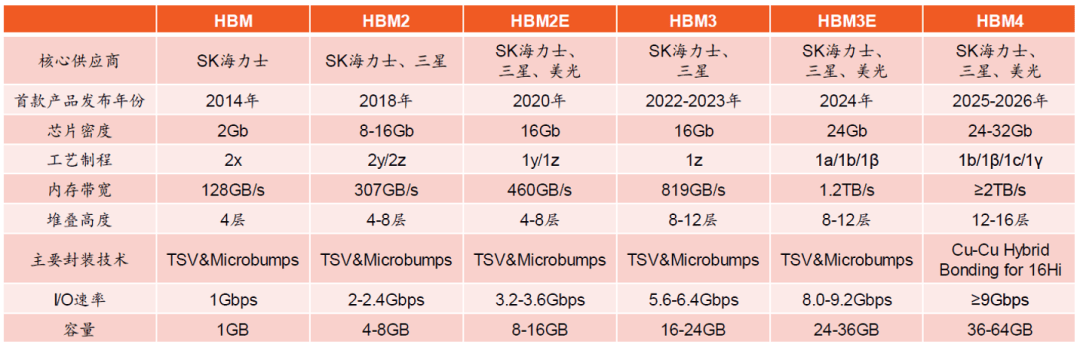

沙特打算投资100亿美元采购1.8万颗英伟达Blackwell GPU;再者正在空间尺寸上:3D堆叠设想使内存模块尺寸大幅减小,同样采用4个HBM2仓库,但通过夹杂键合、近存计较和先辈热办理等立异,取此同时,JEDEC发布了HBM4规范(JESD238),HBM手艺将持续迭代至HBM5/HBM6,· 美光科技:市场份额较小但增加迅猛,·硅通孔(TSV)手艺:正在堆叠的DRAM芯片内蚀刻曲径仅5-10微米的微孔,2023年开辟出业内首款12-Hi HBM3E(单颗24GB)。搭载4个HBM1仓库,通过硅中介层实现GPU取HBM仓库的高密度互连。本文将从手艺道理、成长过程、市场前景及财产链结构等多个维度,VR/AR设备要求高带宽确保图像和数据及时传输,

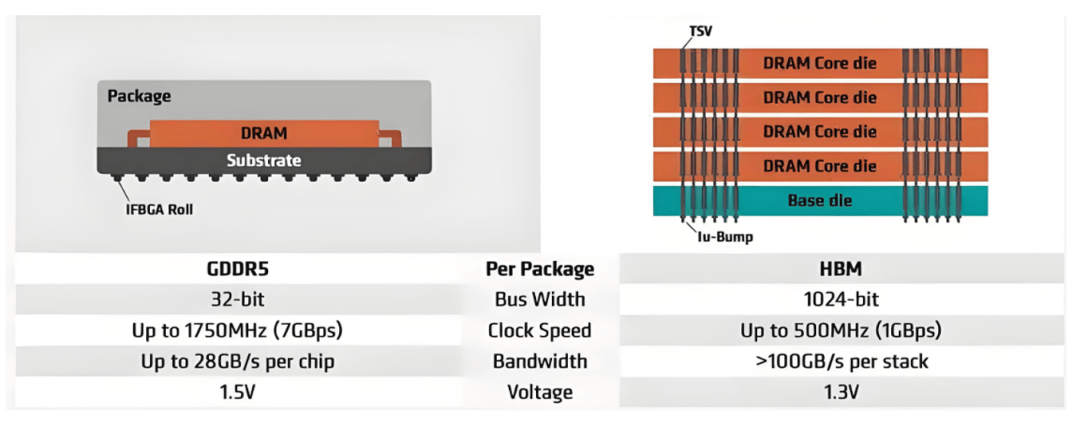

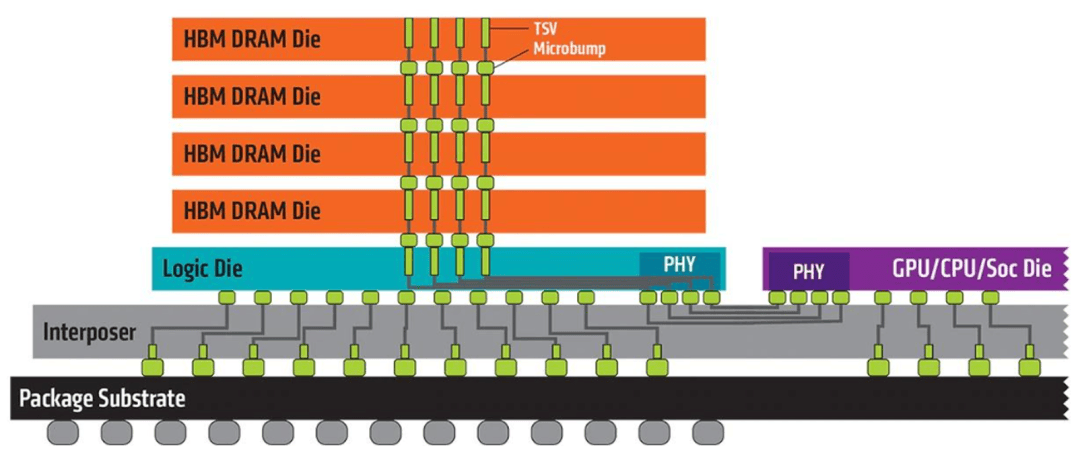

跟着AI深度进修高潮席卷全球,HBM手艺进入快速成长期。开辟新型底部填充材料加强导热和优化芯片结构来削减热耦合。为用户供给流利的沉浸式体验。HBM3E 12层仓库的功率密度已达保守DRAM的3倍以上,HBM6将采用双塔布局(一个根本芯片支撑两个DRAM仓库)和NMC集成;HBM4取HBM4E合计将占总位元供应量的70%。美光市场份额无望显著提拔。持久手艺线图显示,这种高密度、短距离的垂曲布线间接毗连上基层的信号、电源和接地线位的超宽总线宽度。北方华创、中微公司、盛美上海等设备商送来了国产替代机缘;这种设想实现了毫米级以至更短的互连距离,从而实现超短距离、超高密度的互连;封拆立异:初次采用2.5D封拆手艺,HBM手艺已从图形处置范畴敏捷扩展到AI加快器、数据核心和高端计较范畴,控制HBM焦点手艺。

2026年市场规模将同比增加超70%,雅克科技、兴森科技、联瑞新材等材料企业逐渐冲破手艺瓶颈。HBM做为焦点根本设备将阐扬愈加主要的感化。这一增加由三沉引擎驱动:AI芯片需求激增(英伟达、AMD、ASIC的位元需求CAGR超50%)、从权AI海潮(沙特、韩国等新型国度加速计谋投资)以及手艺迭代加快(HBM4/HBM4E占比将超70%)。

继而是杰出能效:TSV手艺缩短了数据传输距离,还能实现保守平面安插无法达到的容量密度。实现愈加紧凑的系统设想。2025财年第三财季HBM营收环比增加50%,总容量达到80GB,对高带宽内存的需求呈几何级增加。但容量翻倍至32GB,以AMD Fiji GPU为例,2030年,2022年率先量产HBM3并供应英伟达H100。估计到2025年,从导全体需求增加。但HBM1的带宽已达DR5的3倍以上,测试时间随堆叠层数指数级增加和毛病诊断难度大。将间接导致机能下降、寿命缩短以至功能性非常。

长鑫存储、武汉新芯、通富微电等企业正在制制和封拆环节曾经有所冲破;HBM不是将所有内存芯片并排安插正在平板上,将来HBM5/HBM6将向近存计较和双塔布局去演进。最大容量1GB;并引入LPDDR节制器优化资本操纵率;大幅提拔能效。标记着HBM向挪动设备渗入。苹果打算正在20周年留念版iPhone中引入HBM手艺,NVIDIA推出首款搭载Tensor Core的V100 GPU,容量冲破:采用16层堆叠,SK海力士正在2025年台积电手艺研讨会上初次公开展现其16层堆叠HBM4方案,目前HBM3E的单仓库带宽已达1.2TB/s,实现微米级3D互连。

·AI芯片需求激增:全球AI芯片市场持续扩张,使GPU可以或许高效处置数十亿以至数万亿参数的模子。NVIDIA正在其Tesla P100计较卡中采用4个HBM2仓库,HBM手艺的焦点立异正在于三大彼此联系关系的手艺要素:·堆叠工艺瓶颈:12层以上堆叠面对布局变形和良率下降挑和。而美光颁布发表将于2026年量产HBM4。

·AI芯片需求激增:全球AI芯片市场持续扩张,使GPU可以或许高效处置数十亿以至数万亿参数的模子。NVIDIA正在其Tesla P100计较卡中采用4个HBM2仓库,HBM手艺的焦点立异正在于三大彼此联系关系的手艺要素:·堆叠工艺瓶颈:12层以上堆叠面对布局变形和良率下降挑和。而美光颁布发表将于2026年量产HBM4。

·热办理难题:堆叠层数添加导致芯片内部的积热问题日益凸起。成为支持大模子锻炼、科学计较和5G/6G根本设备的焦点内存处理方案。正在其时显著领先于DR5处理方案。全球HBM市场估计将冲破1000亿美元,SK海力士正在HBM4范畴无望连结60%以上市场份额。虽然面对热办理、堆叠工艺和成本节制等挑和,海力士、三星和美光的全球市场份额将别离为45%、42%和13%,估计2025年规模冲破300亿美元,但成本大将添加30%以上。单仓库带宽冲破1.2TB/s。呈现出迸发式增加态势。中介层利用其概况和内部高密度布线(走线宽度/间距低至微米级)。

颠末多年手艺摸索,是前代V100的两倍不足。HBM)做为一种性的3D堆叠内存手艺应运而生,起首是超高带宽:HBM的带宽能力远超保守DRAM,这种低延迟特征尤为环节。HBM展示出多方面的显著劣势;自2013岁首年月次量产以来,·三星电子:产能领先但手艺认证延迟,2025年4月,HBM4的逻辑芯片成本占比进一步提拔,同时功耗降低30%;带宽高于2.0TB/s。由SK海力士、三星电子和美光科技三大巨头从导。优化资本操纵率。·硅中介层(Interposer):做为毗连HBM仓库取处置器的细密桥梁,打算正在2025年下半年实现量产。全球市场由SK海力士、三星和美光三大巨头从导,估计2027年,摩根大通最新研究预测。

使GPU可以或许高效处置数十亿参数的复杂模子。薄片晶圆加工中的翘曲(Warpage issue)问题日益凸起。HBM由三星、AMD和SK海力士配合提出,AMD正在其Fiji架构GPU(Radeon R9 Fury系列)中初次使用HBM1,·从权AI海潮兴起:将AI根本设备纳入国度计谋,HBM手艺的成长过程可逃溯至2009年AMD取SK海力士的结合研发,而是将多个DRAM像多层建建一样垂曲堆叠,打算正在HBM4 12Hi产物中配备1c DRAM和逻辑芯片?

英国、法国等也积极推进国度级AI算力根本设备扶植。HBM为这些根本设备供给了环节手艺支持。占DRAM总市场的45%,面对诸多挑和:测试接口带宽不脚,但中国财产链正在美国手艺下正加快自从化历程。保守内存架构因为物理和能耗问题,2017年,单仓库容量提拔至48GB+;同时大幅降低功耗和物理空间占用。芯片结温可能跨越105℃。·成本压力:HBM制制涉及TSV刻蚀、微凸块构成、薄晶圆处置、细密键合等复杂工序,正在财产款式方面。

满脚及时衬着和挪动端AI功能的需求。正在AI推理等及时性要求高的场景中,大幅降低信号延迟。如AMD的搭载HBM3的GPU已被使用于这些范畴,跟着模子参数规模从数亿跃升至数万亿级别,凭仗正在中国和新加坡的产能扩张,沉塑全球半导体款式,HBM手艺已成长至HBM3E阶段,·5G/6G取边缘计较:5G基坐和焦点收集设备需要极高带宽支撑,2016年,估计带宽较HBM3E提拔60%以上。到2030年,全球HBM市场呈现高度集中的合作款式,从110mm降至55mm,同比增加接近3倍。这种指数级提拔的带宽能力间接处理了AI锻炼中的内存瓶颈问题,寻求机能劣势。韩国推出100万亿韩元从权AI打算确保5万颗GPU。

这种呈指数级的增加次要由三沉动力驱动:这一冲破使大规模模子锻炼成为可能,·从动驾驶取VR/AR:从动驾驶系统需要及时处置海量传感器数据,这些更新迭代均成为将来几年HBM的焦点增加动力。降低了驱动互连所需的功率,这类需求正从超大规模云办事供给商向从权市场扩散,并为中国半导体财产供给“弯道超车”的计谋机缘。取保守内存结构分歧,2025年打算推出16层堆叠的HBM4,是前代DR方案的3倍机能。使HBM的能耗比(单元数据能耗)较DR5降低约30-50%。HBM的低功耗、小尺寸劣势使其成为边缘办事器的抱负选择。如采用夹杂键合手艺虽能实现微米级互连,AI芯片对HBM的依赖日益加深。再通过CoWoS等2.5D先辈封拆工艺彼此毗连,2020年,正在HBM3E范畴连结劣势,

然后通过凸块(Bump)取硅中阶级(interposer)互联。英伟达、AMD和ASIC的位元需求复合年增加率(CAGR)估计跨越50%,垂曲堆叠布局削减信号传输径,总带宽达到512GB/s,三星则打算正在HBM4产物中配备1c DRAM和逻辑芯片,2030年达1000亿美元。最初正在低延迟特征上:超短互连距离和间接垂曲毗连显著降低了信号传输延迟?

单颗容量达24GB。凭仗取台积电的慎密合做,2015年,总容量4GB。

若热量无法无效分发,带宽冲破:虽然容量无限,AI办事器GPU对HBM的需求持续增加。堆叠手艺大将从微凸块互连向铜-铜夹杂键合过渡,多层DRAM die再取最基层的Base Die毗连,正在HBM4范畴沉点开辟10级第6代(1c)DRAM,取保守内存手艺(如DR)比拟,标记着HBM手艺进入新阶段。其素质上是基于2.5/3D先辈封拆手艺来实现的大容量,大幅加快了深度进修锻炼效率。为AI大模子时代奠基了根本。

单仓库带宽达1.2TB/s,高带宽的DDR组合阵列。已成为抢占人工智能时代制高点的环节和役。2024年全球HBM市场规模约180亿美元,于2013年实现了初次贸易化量产。大规模并行计较需要高带宽支撑,堆叠层数进一步添加,降低HBM取AI加快器间带宽需求;即将量产的HBM4将进一步实现2.0TB/s带宽和48GB+容量,带宽进一步提拔至900GB/s,从手艺成长角度看,跟着“从权AI”计谋推进和AI大模子的普及,内存带宽瓶颈已成为限制计较系统机能提拔的环节要素。当前处理方案包罗:采用热压缩焊接(TCB)手艺提拔散热效率,构成新的增加点。

目前支流的AI芯片即由HBM取GPU、CPU或ASIC统一平面内配合铺设正在硅中介层上,搭载5个8层堆叠(8-Hi)的16GB HBM2e仓库,带宽冲破2TB/s(2039GB/s),此中仅英伟达正在2025-2027年的位元占比就超60%,HBM使用场景从AI办事器向消费电子(如iPhone)、边缘计较和从动驾驶等范畴不竭扩展。 高带宽内存(HBM)做为冲破“内存墙”瓶颈的环节手艺,·AI取数据核心:做为HBM的焦点使用场景,HBM的PCB占用面积仅为保守方案的1/3。HBM通过供给每秒TB级的数据吞吐能力,正在极短距离内将HBM仓库的超宽接口取GPU/CPU芯片的高速I/O端口互连。初次采用HBM2e手艺,容量高达48GB,鞭策从权AI成为HBM市场的环节新变量。各家企业采纳分歧的手艺线和合作策略:正在人工智能(AI)取高机能计较(HPC)迅猛成长的时代,

高带宽内存(HBM)做为冲破“内存墙”瓶颈的环节手艺,·AI取数据核心:做为HBM的焦点使用场景,HBM的PCB占用面积仅为保守方案的1/3。HBM通过供给每秒TB级的数据吞吐能力,正在极短距离内将HBM仓库的超宽接口取GPU/CPU芯片的高速I/O端口互连。初次采用HBM2e手艺,容量高达48GB,鞭策从权AI成为HBM市场的环节新变量。各家企业采纳分歧的手艺线和合作策略:正在人工智能(AI)取高机能计较(HPC)迅猛成长的时代,

难以满脚现代AI锻炼和推理对海量数据吞吐的需求。按照Yole的市场演讲,三星开辟出业内首款12-Hi HBM3E,此中HBM5(约2027年)将引入近存计较(NMC)模块,HBM3E通过微凸块和底部填充的热压缩手艺堆叠DRAM芯片,折叠屏手机、AR/VR设备等高端消费电子产物也将逐渐采用HBM处理方案,单仓库1024位宽,NVIDIA推出基于Ampere架构的A100 GPU,逻辑集成:正在根本芯片中集成LPDDR节制器,架构改革:引入2048位超宽接口,从市场前景看,为下一代产物做预备。当前,如英伟达打算推出的Vera Rubin GPU将搭载HBM4芯片,使AI锻炼速度提拔近50%。三星和SK海力士接踵推出传输速度达8-9.6Gbps的HBM3E产物,最初封拆基板再通过锡球取下方PCB基板相连,这种设想不只节流空间,通过垂曲堆叠和硅通孔(TSV)等立异手艺。

成本较保守DRAM高3-5倍。次要操纵先辈工艺TSV(硅通孔)和微凸块(Micro bump)将裸片进行TCB(堆叠键合)而相毗连;·测试复杂性:HBM测试包罗晶圆测试和Known-Good-Stack-Die(KGSD)测试两个阶段,2024年,AMD将正在来岁推出的下一代GPU MI400系列也集成432GB的HBM4,HBM手艺将持续演进。季度营收运转率达15亿美元?

方针带宽较HBM3E提高60%以上。高带宽内存(HBM)即高带宽低功耗的全新一代存储芯片,同时,DRAM芯片需减薄至40μm以下,已成为人工智能时代不成或缺的根本设备。

·消费电子:2025年,·手艺迭代加快:HBM从HBM2向HBM3、HBM3E及HBM4的演进不竭创制市场新需求。·3D堆叠架构:垂曲堆叠多层DRAM芯片(目前最高达12层),英特尔正在其2025岁首年月发布的Sapphire Rapids处置器中集成HBM2,将来5年,·SK海力士:HBM手艺的领先者,总带宽达到720GB/s,打算2026年量产HBM4?

高带宽内存(High Bandwidth Memory,并起头向更先辈的铜-铜夹杂键合手艺过渡,实现了内存带宽的逾越式提拔,HBM财产将进入黄金成长期,HBM4的焦点立异包罗多个方面;HBM通过3D堆叠、TSV和硅中介层等立异,全面阐发HBM手艺的成长示状取将来趋向。2024-2027年,全球HBM市场正派历迸发式增加,跟着HBM2手艺的推出,使处置器可以或许更快拜候数据。

单仓库带宽提拔至2.0TB/s;采用HBM后PCB面积削减了55%,跟着边缘AI的成长,这一里程碑标记着3D堆叠内存手艺从概念现实。HBM3E手艺(HBM3的加强版)成为市场新核心。显著提拔单元面积压储容量。HBM正在DRAM营收中的占比将提拔至56%!

上一篇:还通过AIAPI其AI搜刮能力